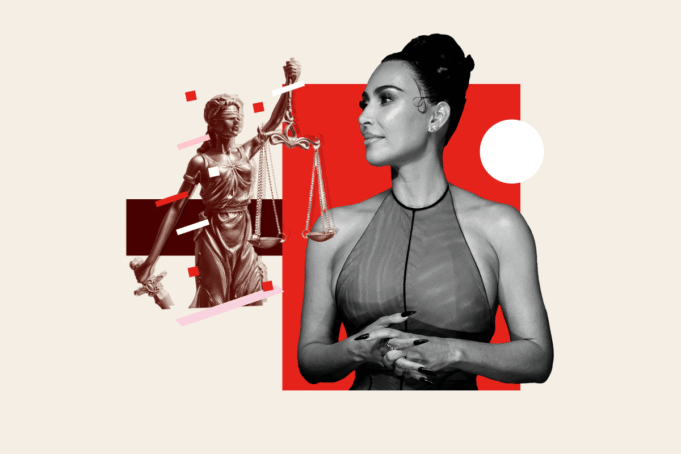

Dopo essersi affidata a ChatGPT per una consulenza legale, il mancato superamento di un esame di diritto pubblico da parte di Kim Kardashian ha rinnovato il dibattito sui pericoli dell’utilizzo dell’intelligenza artificiale generativa (AI) in contesti professionali ad alto rischio. Mentre l’adozione dell’intelligenza artificiale cresce nei settori legale, medico e altri, l’esperienza della star del reality mette in luce le preoccupazioni che le allucinazioni generate dall’intelligenza artificiale possano minare la fiducia del pubblico, creare responsabilità legale e confondere sia gli studenti che i professionisti praticanti.

Newsweek Il rappresentante di Kardashian è stato raggiunto via e-mail per un commento venerdì.

Kim Kardashian fallisce l’esame di avvocato

Lo ha rivelato il co-fondatore di Kardashian-Schemes e aspirante avvocato Fiera della Vanità Intervistato all’inizio di questo mese, ha affermato di aver utilizzato ChatGPT per rispondere a domande legali mentre si preparava per gli esami di giurisprudenza. Secondo Kardashian, il chatbot AI spesso forniva risposte errate, contribuendo a farle fallire numerosi esami legali.

“Utilizzo (ChatGPT) per la consulenza legale, quindi quando ho bisogno di sapere la risposta a una domanda, scatto una foto e la metto lì. Sbagliano sempre. Mi ha fatto fallire il test,” Tutte le fiere L’attrice descrive come la risposta sicura, ma sbagliata, dello strumento porti direttamente alla sua rovina.

Il candore del 45enne ha attirato l’attenzione del pubblico su una tendenza più ampia: studenti e professionisti legali utilizzano sempre più strumenti di intelligenza artificiale generativa come ChatGPT per ricercare, redigere brief e studiare per gli esami. Nonostante siano progettati come macchine di previsione piuttosto che come database di fatti, questi strumenti spesso forniscono informazioni apparentemente logiche ma imprecise. La professione legale ha documentato diversi casi di avvocati che hanno presentato in tribunale documenti contenenti citazioni inesistenti generate da AI, con azioni disciplinari e sanzioni sia negli Stati Uniti che a livello internazionale.

Incerta sulle sue ambizioni legali, Kardashian ha annunciato l’intenzione di sostenere nuovamente l’esame di avvocato in California e continuare i suoi studi legali, ma la sua storia ha spinto gli esperti a emettere nuovi avvertimenti sui limiti dell’intelligenza artificiale in contesti legali.

Pericoli di ChatGPT

Duncan Levine, ex pubblico ministero e docente di diritto presso l’Università di Harvard, ha dichiarato: “Kim Kardashian afferma di utilizzare ChatGPT per consulenza legale è come dire di aver assunto una Magic 8 Ball come co-consulente. L’intelligenza artificiale può essere fiduciosa pur essendo completamente sbagliata, e questa è una combinazione pericolosa dal punto di vista legale.” Newsweek.

Ha aggiunto che “il rischio non è che stia studiando tecnologia”, ma che i suoi milioni di follower “potrebbero pensare che la competenza legale sia solo a portata di mano”.

“Per superare l’esame ci vogliono giudizio, etica ed esperienza: tre cose: non esiste un algoritmo. ChatGPT può scrivere un buon argomento conclusivo, ma non può tenerti fuori di prigione”, ha detto Levine.

Matthew Sagg, professore di diritto presso la Emory University School of Law, ha sottolineato in una dichiarazione Newsweek Che “l’intelligenza artificiale produttiva può essere uno strumento molto utile per gli avvocati, ma solo nelle mani di persone che conoscono effettivamente il diritto.

“Tutto ciò che ChatGPT ti dice sulla legge sembra ragionevole, ma è pericoloso se non hai le competenze o il contesto per vedere cosa manca e cosa è allucinante”, ha detto.

Secondo OpenAI, creatore di ChatGPT, le allucinazioni sono “casi in cui un modello produce con sicurezza una risposta che non è vera”.

L’avvocato ed esperto di intelligenza artificiale Logan Brown ha riportato queste informazioni Newsweek Che “ChatGPT (e altri strumenti di intelligenza artificiale) possono essere e spesso sono sbagliati”.

“Questi sistemi sembrano sicuri nonostante siano praticamente chiusi e possono essere pericolosi se le persone fanno affidamento su di essi per questioni serie come la consulenza legale”, ha affermato. “Utilizzare ChatGPT come autorità di scelta giuridica senza una guida affidabile è in realtà rischioso. Questo è esattamente il motivo per cui abbiamo associazioni degli avvocati.”

Harry Sarden, professore di diritto della University of Colorado Law School, ha aggiunto: “Quando qualcuno ha una domanda legale, l’opzione migliore è chiedere a un avvocato, se disponibile. Tuttavia, la ricerca mostra che circa l’80% degli americani ha problemi legali ma non ha accesso o non può permettersi un avvocato. In situazioni come questa, ChatGPT probabilmente non è un’opzione perfetta per migliorarli dal punto di vista legale. Domande, e certamente non buone quanto quelle di un avvocato, per quanto moderni gli strumenti di intelligenza artificiale di ChatGPT generalmente forniscono risposte abbastanza ragionevoli a domande legali di base.”

Ha chiarito: “Per essere chiari, non consiglio l’uso dell’intelligenza artificiale in questioni legali complesse e, in questi casi, le persone dovrebbero sempre consultare un avvocato. Ma per questioni legali di base in cui un avvocato non è un’opzione, l’intelligenza artificiale tende a rappresentare un miglioramento rispetto all’alternativa, che spesso è costituita da congetture di amici e familiari o da una cattiva consulenza legale”.

Conseguenze dell’eccessiva dipendenza

Mark Bartholomew, professore di diritto e vice preside per la ricerca e lo sviluppo delle facoltà presso l’Università della Buffalo School of Law, ha affermato Newsweek Che Kardashian “sta facendo ciò che è giusto”, ma “il pericolo è l’eccessiva dipendenza”.

“Come in altri campi, l’intelligenza artificiale sta sconvolgendo l’educazione giuridica. Non c’è modo di escludere completamente l’educazione giuridica dall’intelligenza artificiale”, ha spiegato. “L’intelligenza artificiale ha allucinazioni: inventa casi e può sbagliare la legge. Quindi, qualsiasi studente di giurisprudenza o avvocato responsabile dovrebbe ricontrollare le risposte del chatbot alle sue domande. Inoltre, essere un avvocato implica molto più che semplicemente trovare risposte. Gli avvocati devono sviluppare le proprie capacità leggendo così tanti casi, analizzando leggi, argomentando, ecc. che potrebbero sviluppare preoccupazioni sulla legge. Come avvocato a volte non c’è alternativa a fare il proprio lavoro.”

Thomas R. dell’Università di Drexel. La dottoressa Anat Leor, assistente professoressa di diritto presso la Cline School of Law, ha fatto eco all’avvertimento sulla dipendenza: “Quando (Kardashian) discute quella parte dell’intervista, dice immediatamente che ‘hanno sempre torto’ e suggerisce che l’uso dello strumento l’ha delusa. La sua combinazione di fare affidamento su di esso e di fare affidamento su di esso per rispondere correttamente. Questo è un avvertimento importante per chiunque utilizzi ChatGPT in situazioni ad alto rischio come studiare per l’avvocato o qualsiasi esame con conseguenze reali.”

Il “problema” emergente dell’intelligenza artificiale

Frank Pasquale, professore di diritto alla Cornell Tech e alla Cornell Law School, ha osservato che i documenti legali imprecisi generati dall’intelligenza artificiale sono “già un grosso problema”.

“Molti avvocati sono stati autorizzati a citare casi falsi, anche negli Stati Uniti e in Australia. Il problema non potrà che peggiorare con la diffusione dell’intelligenza artificiale”, ha affermato.

Bartholomew è d’accordo, dicendo: “Stiamo già riscontrando molti problemi con l’uso dell’intelligenza artificiale per creare documenti legali. Il problema è che gli avvocati si affidano alle risposte dei chatbot senza esaminarle e poi forniscono memorie legali che contengono assurdità. I giudici stanno iniziando a imporre ingiunzioni contro questo tipo di legge per far rispettare la pigrizia delle proprie regole e sfruttare la pigrizia della legge.”

Cosa succede dopo?

Nonostante i rischi, gli esperti legali concordano sul fatto che l’intelligenza artificiale generativa rimarrà probabilmente una componente importante della pratica professionale.

Il consenso è che gli strumenti di intelligenza artificiale dovrebbero servire solo come punto di partenza – soggetto a un rigoroso controllo umano – e non come sostituto di una consulenza legale competente. Per gli studenti, i professionisti e il pubblico in generale, l’esperienza di Kardashian sottolinea la necessità fondamentale di affrontare i risultati dell’intelligenza artificiale con scetticismo e di sostenere gli standard tradizionali di responsabilità professionale laddove sono in gioco vite e mezzi di sussistenza.