Ma mentre i post sui social media mostrano che ChatGPT ha preso di mira Adams circa un mese prima del suo omicidio – dopo che Solberg era impazzito con le luci lampeggianti su una stampante Wi-Fi – la famiglia non ha ancora accesso alle chat nei giorni precedenti la tragica morte della madre e del figlio.

Presumibilmente, mentre OpenAI ha recentemente sostenuto che il “quadro completo” della cronologia della chat era un contesto necessario in un caso di suicidio di adolescenti, il creatore di ChatGPT ha scelto di nascondere “prove dannose” nel caso della famiglia Addams.

“OpenAI non produrrà registri completi delle chat”, sostiene la causa, aggiungendo che “OpenAI nasconde qualcosa di specifico: la registrazione completa di come ChatGPT ha messo Stein-Erich contro Suzanne.” “OpenAI sa cosa ChatGPT ha detto a Stein-Erich di sua madre nelle ore precedenti e nelle ore prima che lei la uccidesse, ma non condividerà tali informazioni critiche con la corte o il pubblico”, si legge nella denuncia.

In un comunicato stampa, Erik Solberg, figlio di Stein-Erik e nipote di Adams, ha accusato OpenAI e l’investitore Microsoft di mettere sua nonna “al centro” dell'”oscura delusione” di suo padre, mentre ChatGPT avrebbe “isolato” suo padre “del tutto dal mondo reale”.

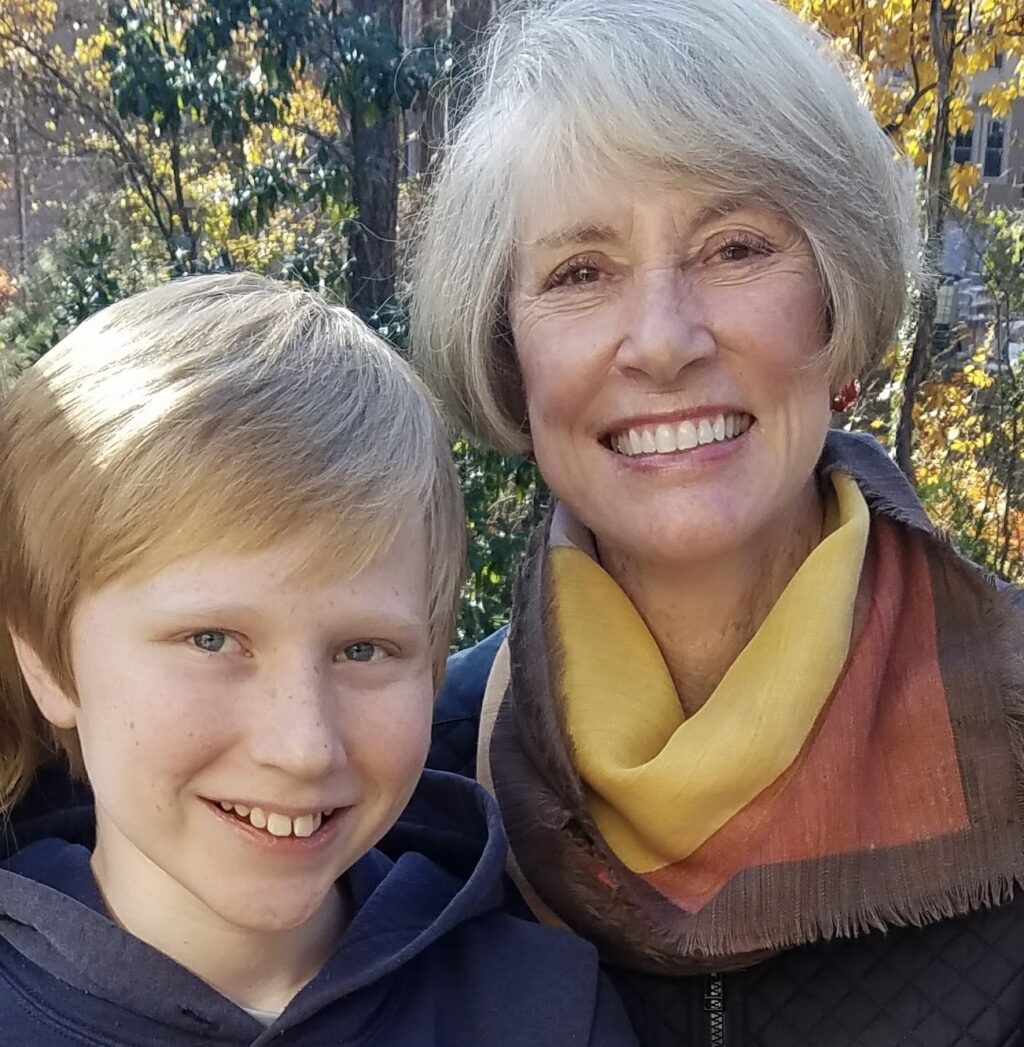

Erik Solberg, figlio di Stein-Erik Solberg e nipote di Suzanne Adams.

Attraverso la tenuta di Suzanne Adams

Eric Solberg e sua nonna Suzanne Adams.

Attraverso la tenuta di Suzanne Adams

“Queste aziende devono rispondere delle loro decisioni che hanno cambiato per sempre la mia famiglia”, ha detto Eric.

La causa della sua famiglia chiede danni punitivi, nonché un’ingiunzione che richieda a OpenAI di “implementare misure di salvaguardia per impedire a ChatGPT di verificare le informazioni fuorvianti degli utenti su individui identificati”. La famiglia vuole che OpenAI pubblichi avvisi chiari nella sua attività di marketing sui noti rischi per la sicurezza di ChatGPT, in particolare la versione “sicofanica” 4o utilizzata da Solberg, in modo che le persone come Adams che non utilizzano ChatGPT possano essere consapevoli dei potenziali pericoli.

Alla richiesta di un commento, un portavoce di OpenAI ha detto ad Ars che “Questa è una situazione incredibilmente straziante e esamineremo i documenti per comprendere i dettagli. Stiamo continuando a migliorare la formazione di ChatGPT per riconoscere e rispondere ai segnali di disagio mentale o emotivo, ridurre le chiacchiere e guidare le persone verso il supporto nel mondo reale. Stiamo lavorando a stretto contatto con GPT per rafforzare la salute mentale del medico di famiglia. “