OpenAI ricercatori provare un nuovo approccio Progettare reti neurali per rendere i modelli di intelligenza artificiale più facili da comprendere, eseguire il debug e gestire. I modelli sparsi possono offrire alle aziende una migliore comprensione di come questi modelli prendono decisioni.

Comprendere il modo in cui i modelli scelgono di rispondere è un grande punto di forza dei modelli di ragionamento per le organizzazioni e può fornire un livello di fiducia quando le organizzazioni guardano ai modelli di intelligenza artificiale per ottenere informazioni.

Il metodo richiedeva agli scienziati e ai ricercatori di OpenAI di esaminare e valutare i modelli non analizzando le prestazioni post-allenamento, ma aggiungendo interpretabilità o comprensione attraverso circuiti sparsi.

OpenAI rileva che gran parte della trasparenza nei modelli di intelligenza artificiale deriva dal modo in cui la maggior parte dei modelli è progettata, quindi è necessario creare soluzioni alternative per comprendere meglio il comportamento del modello.

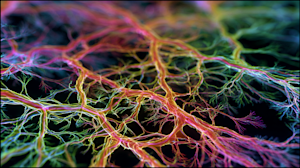

“Le reti neurali alimentano i sistemi di intelligenza artificiale più potenti di oggi, ma rimangono sfuggenti”, ha scritto OpenAI in un post sul blog. “Non scriviamo questi modelli con istruzioni esplicite passo passo. Invece, imparano adattando miliardi di connessioni interne, o pesi, fino a quando non padroneggiano un compito. Progettiamo le regole di formazione, ma non i comportamenti specifici che emergono, e il risultato è una fitta rete di connessioni che nessun essere umano può facilmente svelare.”

Per migliorare l’interpretabilità del mix, OpenAI ha studiato un’architettura che ne facilita la comprensione addestrando reti neurali semplici. Il team ha addestrato modelli linguistici con un’architettura simile ai modelli esistenti, come GPT-2, utilizzando lo stesso schema di formazione.

Il risultato: migliore interpretabilità.

Il percorso verso l’interpretabilità

OpenAI afferma che è importante capire come funzionano i modelli per darci un’idea di come prendono le loro decisioni perché hanno un impatto nel mondo reale.

L’azienda definisce l’interpretabilità come “metodi che ci aiutano a capire perché un modello produce un particolare output”. Esistono diversi modi per ottenere l’interpretabilità: l’interpretabilità della catena di pensiero, spesso utilizzata dai modelli di ragionamento, e l’interpretabilità meccanica, che implica il reverse engineering della struttura matematica di un modello.

OpenAI si è concentrato sul miglioramento dell’interpretabilità meccanica, affermando che questa “è stata meno utile finora, ma in linea di principio potrebbe fornire una descrizione più completa del comportamento del modello”.

Secondo OpenAI, “l’interpretabilità meccanicistica, che tenta di spiegare il comportamento del modello al livello più dettagliato, può fare meno ipotesi e darci più fiducia. Ma il percorso dai dettagli di basso livello alle spiegazioni di comportamenti complessi è molto più lungo e difficile.”

Una migliore interpretabilità fornisce una migliore supervisione e fornisce segnali di allarme tempestivi se il comportamento del modello non è più in linea con la politica.

OpenAI ha osservato che migliorare l’interpretabilità meccanica era “una scommessa molto ambiziosa”, ma la ricerca sulle reti sparse ha migliorato questo aspetto.

Come risolvere un modello

Per districare le complesse connessioni create da un modello, OpenAI ha prima tagliato molte di queste connessioni. I modelli di trasformatori come GPT-2 hanno migliaia di connessioni, quindi il team ha dovuto “azzerare” questi circuiti. Ciascuno parlerà solo con un numero selezionato, rendendo le connessioni più snelle.

Il team ha quindi eseguito il “tracciamento dei circuiti” sui compiti per creare raggruppamenti di circuiti interpretabili. Il compito finale prevedeva la potatura del modello “per ottenere il circuito più piccolo che produce la perdita target nella distribuzione target”. Secondo OpenAI. Ha mirato a una perdita di 0,15 per isolare completamente i nodi e i pesi responsabili del comportamento.

“Abbiamo dimostrato che l’eliminazione dei nostri modelli a peso scarso produce circuiti circa 16 volte più piccoli nei nostri compiti rispetto alla potatura di modelli densi con perdite di pre-allenamento simili. Siamo anche in grado di creare circuiti arbitrariamente accurati a scapito di più bordi. Ciò dimostra che i circuiti per comportamenti semplici sono significativamente più risolvibili e localizzabili nei modelli a peso scarso che nei modelli densi”, afferma il rapporto.

I modelli piccoli diventano più facili da addestrare

Sebbene OpenAI sia riuscita a creare modelli sparsi e più facili da comprendere, rimangono significativamente più piccoli rispetto alla maggior parte dei modelli di base utilizzati dalle aziende. Le organizzazioni utilizzano sempre più modelli più piccoli, ma modelli pionieristici come l’ammiraglia GPT-5.1 continueranno a beneficiare di una migliore interpretabilità su tutta la linea.

Anche altri sviluppatori di modelli mirano a capire come pensano i modelli di intelligenza artificiale. antropicoLa società, che da tempo conduce ricerche sull’interpretabilità, ha recentemente rivelato di aver “hackerato” il cervello di Claude, e Claude se ne è accorto. Meta Si sta anche cercando di scoprire come i modelli di ragionamento prendono le loro decisioni.

Poiché sempre più organizzazioni si rivolgono ai modelli di intelligenza artificiale per prendere decisioni importanti per le loro aziende e, in ultima analisi, per i loro clienti, la ricerca per comprendere come pensano i modelli fornirà la chiarezza di cui molte organizzazioni hanno bisogno per fare maggiore affidamento sui modelli.