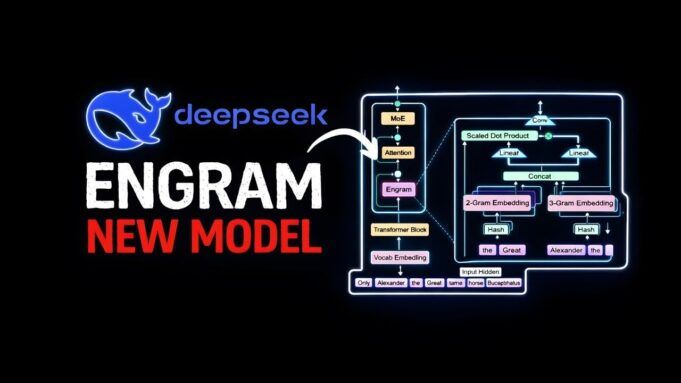

I Transformer sono davvero l’apice dell’innovazione dell’intelligenza artificiale o sono solo un modo eccessivamente ingegnerizzato per risolvere problemi semplici? Prompt Engineering esplora il modo in cui l’innovativo DeepSeek Engram sfida il predominio delle architetture basate su Transformer proponendo un’alternativa audace: trattare i Transformers come poco più di questo. hashmap costose. Questa affermazione provocatoria deriva dalla capacità di Engram di separare semplici operazioni di memoria dalla logica complessa, offrendo un modo più intelligente ed efficiente per gestire i calcoli del modello linguistico. Ripensando il modo in cui vengono elaborate le attività, Engram non solo riduce gli sprechi computazionali, ma ridefinisce anche il modo in cui scalabilità e velocità possono apparire nei modelli linguistici di grandi dimensioni.

In questa panoramica analizzeremo le principali innovazioni dietro gli engrammi, compreso il loro utilizzo ricerca basata su hash Per il suo meccanismo di controllo sensibile al contesto per compiti di memoria semplici e per ragionamenti più profondi. Imparerai come questa architettura riduce il carico della GPU, migliora la latenza e sfida le inefficienze dei Transformer tradizionali. Ma non è poi così intuitivo, la dipendenza di Engram dalle tabelle di ricerca statiche e dalle potenziali collisioni di hash solleva importanti domande sulla sua adattabilità e accuratezza. Potrebbe essere questo il futuro dell’intelligenza artificiale o solo un passo verso qualcosa di più grande? Esploriamo le implicazioni e i limiti di questo nuovo approccio.

La svolta LLM di DeepSeek Engram

TL;DR Fatti principali:

- Engram introduce un’architettura innovativa per modelli linguistici di grandi dimensioni (LLM) che separa semplici attività di richiamo dalla logica complessa, ottimizzando l’efficienza computazionale e la scalabilità.

- Le attività di memoria statica come il recupero dei fatti vengono gestite utilizzando ricerche basate su hash, mentre le attività di logica dinamica utilizzano livelli di trasformazione per calcoli approfonditi.

- Il design di Engram riduce il carico della GPU memorizzando le tabelle di ricerca nella RAM di sistema, riducendo i costi dell’hardware e migliorando l’efficienza di implementazione.

- I benchmark delle prestazioni mostrano miglioramenti significativi sia nel richiamo delle conoscenze che nelle attività di ragionamento, consentendo un’elaborazione più rapida e accurata senza aumentare il numero di strati Transformer.

- Nonostante i loro vantaggi, gli engrammi devono affrontare sfide come collisioni di hash, dipendenza da tabelle di ricerca statiche e limitazioni nella gestione di modelli altamente specifici o complessi.

problema con il trasformatore

I trasformatori, l’architettura fondamentale alla base di molti LLM, applicano lo stesso sforzo computazionale a tutte le attività, indipendentemente dalla complessità. Che si tratti di recuperare un fatto semplice come “Parigi è la capitale della Francia” o di risolvere un problema logico impegnativo, Transformers tratta questi compiti ugualmente bene. Questo stesso approccio porta a inefficienze: semplici funzioni di richiamo coinvolgono inutilmente più livelli di Transformer, aumentando i costi computazionali e limitando la scalabilità. Man mano che i LLM diventano più grandi e complessi, queste inefficienze diventano sempre più problematiche, ostacolando la loro capacità di lavorare efficacemente negli scenari del mondo reale.

La soluzione innovativa di Engram

Engram introduce un’architettura innovativa che risolve queste inefficienze incorporando un meccanismo di memoria condizionale. Questo meccanismo separa le attività di memoria statica, come il recupero dei fatti, dalle attività di ragionamento dinamico che richiedono calcoli approfonditi. I componenti principali di questo sistema includono:

- Funzioni di memoria statica: Le semplici attività di richiamo vengono gestite utilizzando ricerche basate su hash, evitando la necessità di calcoli approfonditi e preservando le risorse.

- Logica dinamica: Le attività complesse che richiedono una comprensione sottile vengono elaborate dai livelli del trasformatore, garantendo risposte accurate e consapevoli del contesto.

- Gating sensibile al contesto: Un meccanismo di gating garantisce che la memoria recuperata si allinei al contesto dell’attività mantenendo sia l’accuratezza che l’efficienza.

Assegnando le risorse computazionali in base alla complessità dell’attività, Engram raggiunge un equilibrio tra velocità e precisione, rendendolo un’alternativa più efficiente ai tradizionali modelli basati su trasformatori.

Engrammi di DeepSeek: Transformers sono solo hashmap costose

aumentare la tua conoscenza IA di DeepSeek Esplorando una selezione di articoli e guide sull’argomento.

Come funziona un engram?

L’architettura degli engrammi utilizza combinazioni di token, o n-grammi, estratti dal testo di input per ottimizzare l’elaborazione delle attività. Questi n-grammi vengono sottoposti ad hashing per recuperare gli incorporamenti da una tabella di ricerca preaddestrata archiviata nella RAM di sistema. Il processo si svolge in questo modo:

- Gli N-grammi vengono generati dal testo di input, acquisendo schemi e sequenze chiave.

- Gli n-grammi vengono sottoposti ad hashing per trovare gli incorporamenti rilevanti nella tabella di ricerca preaddestrata.

- Un meccanismo di gating valuta la pertinenza degli incorporamenti recuperati in base al contesto specifico dell’attività.

Questo design scarica le attività di memoria statica su ricerche basate su hash, liberando i livelli del trasformatore per attività che richiedono una logica intensiva. Riducendo il carico computazionale su Transformer, Engram non solo migliora l’efficienza ma riduce anche la latenza durante l’inferenza, consentendo prestazioni più veloci e reattive.

miglioramento delle prestazioni

Engram fornisce miglioramenti significativi delle prestazioni in una varietà di benchmark, dimostrando la sua efficacia nell’ottimizzazione dei calcoli LLM. Le principali aree di miglioramento includono:

- Richiamo della conoscenza: Compiti come MMLU e ARC AGI beneficiano di una maggiore precisione e di un ridotto sovraccarico computazionale, dimostrando la capacità degli engrammi di gestire in modo efficiente compiti di memoria statica.

- Funzione logica: La capacità del trasformatore libero porta a prestazioni migliori in problemi complessi tra cui il ragionamento matematico e l’inferenza logica.

Riallocando le risorse per concentrarsi sulla logica complessa, Engram Transformer consente un’elaborazione più profonda e accurata senza aumentare il numero di livelli. Ciò si traduce in un completamento più rapido delle attività e in una migliore scalabilità, rendendolo una soluzione pratica per applicazioni su larga scala.

efficienza dell’hardware

La dipendenza di Engram dalle ricerche basate su hash introduce diverse ottimizzazioni hardware che ne rendono la distribuzione più accessibile ed economica. Questi includono:

- Carico GPU ridotto: La tabella di ricerca è archiviata nella RAM di sistema, riducendo il carico sulla costosa memoria della GPU e riducendo i costi hardware complessivi.

- Quote minime: Gli incorporamenti vengono già ottenuti durante il calcolo, garantendo un’elaborazione fluida ed efficiente senza alcun ritardo.

Queste efficienze hardware riducono gli ostacoli all’implementazione del LLM su larga scala, consentendo alle organizzazioni di utilizzare funzionalità di intelligenza artificiale avanzate senza costi proibitivi. Ciò rende Engram particolarmente attraente per i settori che richiedono soluzioni AI scalabili ed efficienti.

Limitazioni da considerare

Sebbene gli engram offrano molti vantaggi, non sono privi di sfide. Alcune limitazioni principali includono:

- Collisione hash: L’uso di ricerche basate su hash può produrre imprecisioni, soprattutto in attività che richiedono elevata precisione o recupero di dati univoci.

- Tabelle di ricerca statiche: La dipendenza da tabelle di ricerca preaddestrate limita la capacità del modello di adattarsi dinamicamente durante l’inferenza, riducendo la flessibilità in alcuni scenari.

- Vincoli N-grammi: Fare affidamento sugli n-grammi può ostacolare la capacità del modello di acquisire modelli o relazioni complessi nei dati di input.

- Dominio specifico: La performance degli engrammi in aree di nicchia o altamente specializzate rimane inutilizzata, lasciando spazio a ulteriori esplorazioni e perfezionamenti.

Queste limitazioni evidenziano aree in cui ulteriori attività di ricerca e sviluppo potrebbero migliorare le capacità di Engram, garantendone l’applicabilità a una gamma più ampia di casi d’uso.

implicazioni più ampie

La struttura degli engram si ispira alla cognizione umana, riflettendo la dissociazione tra il richiamo rapido e automatico (Sistema 1) e il ragionamento deliberato e faticoso (Sistema 2). Questo approccio rappresenta uno sviluppo significativo nell’architettura LLM, simile all’introduzione dei meccanismi di attenzione nei modelli precedenti. Allineando i metodi computazionali con i requisiti delle attività, Engram riduce i costi e migliora la scalabilità, rendendo l’intelligenza artificiale avanzata più accessibile a un pubblico più ampio. Il suo impatto potrebbe estendersi oltre il LLM, plasmando le future innovazioni nell’intelligenza artificiale enfatizzando l’efficienza, l’elaborazione specifica delle attività e l’ottimizzazione delle risorse.

Credito mediatico: ingegneria rapida

Archiviato in: AI, Notizie sulla tecnologia, Notizie principali

Ultime offerte di gadget Geeky

Divulgazione: Alcuni dei nostri articoli contengono link di affiliazione. Se acquisti qualcosa tramite uno di questi link, Geeky Gadgets può guadagnare una commissione di affiliazione. Scopri la nostra politica di divulgazione.