E se il sistema di intelligenza artificiale su cui facciamo affidamento sulla forza della nostra vita, le nostre auto, la nostra assistenza sanitaria, persino i nostri sistemi finanziari, possono essere rapiti con alcune linee abilmente progettate del codice? Non è solo una fantasia diastopiana; Questa è una realtà in crescita. Recenti prove su modelli AI avanzati Gemelli 2.0 E Grocke 4 Rivelare debolezze innaturali, affermando quanto facilmente questi sistemi possano essere manipolati o sfruttati. Nonostante la loro raffinatezza, questi modelli sollevano domande immediate sulla sicurezza dell’IA in importanti applicazioni, sconcertando i metodi di fronte a attacchi innovativi. Verità incerta? L’intelligenza artificiale non è solo possibile, è distrattamente facile.

Tutto ciò che riguarda l’IA fornisce maggiori informazioni sulla pericolosa fragilità del sistema di intelligenza artificiale più avanzato di oggi, spiegando come l’attrezzatura progettata per simulare gli attacchi sta evidenziando i loro punti più deboli. Da Iniezione del payload Per i test batch a più modelli, cercherai tecniche che evidenziano questi punti deboli e implicazioni per la protezione dell’intelligenza artificiale. Ma tutto ciò non è una cattiva notizia, un tentativo crescente di rafforzare il salvataggio e le potenziali minacce. Mentre leggi, otterrai una comprensione più profonda dei rischi, le attrezzature devono sopprimere la necessità di cooperare per raggiungere il futuro dell’intelligenza artificiale per combatterli. Quanto è sicuro l’IA modella il nostro mondo? La risposta potrebbe sorprenderti.

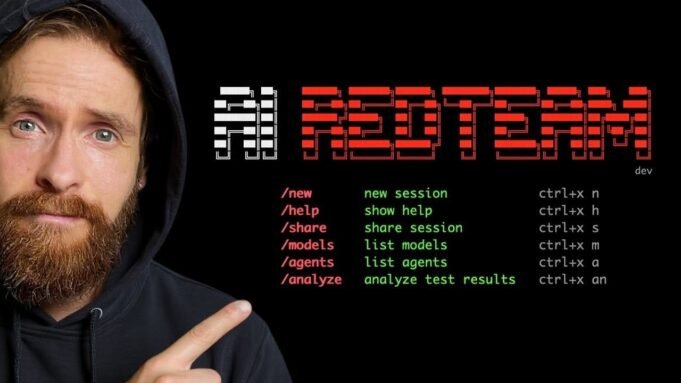

Strumento di test vulnerabile AI

Tl; Dr Key Takeaways:

- Lo strumento AI RedTeam è una piattaforma open source progettata per ridurre e ridurre le debolezze simulando gli attacchi nel modello AI e valutando il salvataggio.

- Le caratteristiche principali includono test del modello solista, test batch e una “modalità di Dio” avanzata per una valutazione completa della sicurezza, utilizzando tecniche come l’iniezione del payload e gli attacchi in formato di risposta.

- Il dispositivo supporta diversi modelli di intelligenza artificiale, come Gemini 2.0, Grocke 3, GROCK 4 e GPT OSS 120B e fornisce informazioni sui loro livelli separati di forza di sicurezza.

- Ciò genera nuovi vettori di attacco, inclusi il payload basato su stringa e basato sul codice per testare l’elaborazione del linguaggio naturale del modello AI e le capacità di gestione dei comandi eseguibili.

- Il miglioramento pianificato include capacità correlate automaticamente, catene di attacco a più fasi e analisi dell’esecuzione, mira ad adattarsi ai pericoli del mondo reale e migliorare i test di sicurezza dell’intelligenza artificiale.

Come funziona lo strumento AI Redteam

Lo strumento AI Redteam è progettato per testare la sicurezza del modello AI utilizzando il codice open source modificato. Si integra con OpenRouter, consentendo di utilizzare e valutare più modelli di intelligenza artificiale attraverso un’interfaccia integrata. Questa compatibilità estende modelli ampiamente utilizzati come Gemini 2.0, Grocke 3, GROCK 4 e GPT OSS 120B. La sua architettura modulare garantisce flessibilità, in modo da poter fare qualsiasi cosa, dalla valutazione vulnerabile di base alla simulazione avanzata di attacco.

Il design dello strumento enfatizza l’adattabilità. Che tu sia un ricercatore, sviluppatore o professionista della sicurezza, offre una piattaforma per rilevare la forza e le debolezze del sistema AI. Centralizzando l’accesso a diversi modelli, semplifica il processo di test e confronta il loro salvataggio, rendendolo una risorsa preziosa per perseguire la sicurezza dell’IA.

Caratteristiche principali: attacchi di test e simulazione

Questo dispositivo facilita diverse funzionalità per soddisfare vari requisiti di test. Queste caratteristiche sono progettate per fornire approfondimenti attuabili per evidenziare le debolezze e migliorare la difesa dell’IA:

- Test a modello singolo: Presta attenzione alla valutazione della sicurezza di un modello di intelligenza artificiale specifico per identificare i tuoi punti deboli unici.

- Test batch: Prova più modelli contemporaneamente per rilevare il modello di debolezza in vari sistemi.

- Godmode: Per gli utenti avanzati, questa modalità combina diverse tecniche di attacco, offrendo una valutazione completa di un salvataggio del modello.

L’attrezzatura impiega ha preceduto attacchi determinati come attacchi in formato di risposta, iniezioni di carico utile e sforzi di bypass. Queste tecniche sfruttano i punti deboli generali, tra cui scarsa verifica input e misure di sicurezza pertinenti insufficienti. Ad esempio, gli attacchi in formato di reazione manipolano la struttura dell’output dell’IA, mentre i carichi utili introducono input dannosi per testare la flessibilità del sistema di iniezione. Imitando questi scenari, lo strumento fornisce una comprensione più profonda di come i modelli di intelligenza artificiale rispondono a potenziali minacce.

In che modo gli hacker sfruttano i sistemi di intelligenza artificiale come Gemini 2.0 e Grake 4

Vedi guide più pertinenti della nostra collezione completa Ai cybercity Che potresti sembrare utile.

I punti deboli del modello rivelano

Vari livelli di vulnerabilità sono stati rilevati nei test condotti su modelli come Gemini 2.0 e Grocke 4. Alcuni modelli, come GPT OSS 120B, hanno dimostrato una forte difesa in scenari specifici, hanno mostrato la loro capacità di gestire efficacemente alcuni tipi di attacchi. Tuttavia, altri, come Groke 3, lottano con payload più complessi, evidenziando intervalli significativi nella loro sicurezza.

Questi risultati sottolineano l’importanza del continuo miglioramento della sicurezza dell’IA. Anche i modelli più avanzati possono dimostrare punti deboli, specialmente quando si affrontano romanzi o metodi di attacco raffinati. Identificando questi punti deboli, lo strumento fornisce una base per sviluppare un sistema di intelligenza artificiale più sicuro.

Nuovo payload e vettore di attacco

Una delle caratteristiche straordinarie dello strumento è la capacità di generare nuovi vettori di attacco. Utilizzando modelli avanzati come GPT-5, forma payload basati su stringhe e in codice progettati per sfruttare punti deboli specifici. Questi payload sono pronti a testare vari aspetti della funzionalità del modello AI:

- Payload basato su stringa: Tassa le capacità di elaborazione del linguaggio naturale di un modello, testando la sua capacità di interpretare e reagire all’input intricato.

- Payload basato sul codice: Valuta quanto bene un modello gestisce gli ordini eseguibili, identificando potenziali punti deboli nell’argomento di elaborazione.

Questa capacità migliora l’accuratezza dei test e fornisce informazioni sui potenziali pericoli del mondo reale. Imitando una varietà di paesaggi, l’equipaggiamento equipaggia i ricercatori e gli sviluppatori con le conoscenze richieste per rafforzare il salvataggio dell’IA.

Test test con elaborazione batch

Un’altra caratteristica importante dello strumento di elaborazione batch è da cui è possibile valutare molti modelli utilizzando lo stesso carico utile. Questo approccio non solo risparmia tempo, ma consente anche un’analisi più completa delle debolezze in vari sistemi. Confrontando i risultati, è possibile identificare il modello di debolezza e ottenere una chiara comprensione di come diversi modelli rispondono agli stessi pericoli.

Questa funzione è particolarmente utile per le organizzazioni che gestiscono molti sistemi di intelligenza artificiale. Ciò semplifica il processo di valutazione della loro sicurezza e fornisce una base per l’implementazione di riforme mirate. Rimalsline del test, lo strumento aiuta a garantire che i modelli AI siano meglio attrezzati per gestire potenziali attacchi.

Miglioramento pianificato: adattamento ai pericoli del mondo reale

Gli sviluppatori dello strumento AI RedTeam stanno attivamente lavorando sulla promozione per renderlo ancora più efficace. Lo scopo di queste caratteristiche pianificate è ripetere la natura adattiva dei pericoli del mondo reale, che fornisce una piattaforma più completa per i test di sicurezza dell’IA:

- Capacità di riposo automatico: Raffinamento della generazione di payload e test perfezionano automaticamente le strategie dell’attacco.

- Catena di attacco in più fasi: Segui paesaggi complessi in cui diversi punti deboli vengono sfruttati nella sequenza.

- Biblioteca navigazione: Semplice accesso a una riserve di tecniche di attacco, rendendo più facile rilevare e applicare vari metodi.

- Analisi dell’esecuzione: Valuta l’efficacia di vari metodi di attacchi, fornendo approfondimenti dettagliati sotto la loro influenza sul modello AI.

Questi arricchidi sono progettati per affrontare la natura sviluppata delle minacce di intelligenza artificiale, garantendo che lo strumento rimanga una risorsa preziosa per ricercatori e sviluppatori.

Sfide e limiti attuali

Nonostante la sua capacità, lo strumento deve affrontare molte sfide che limitano il suo scopo attuale. Le caratteristiche di bug e incomplete possono interrompere la sua efficacia, soprattutto quando si verificano scenari più complessi. Inoltre, alcuni modelli dimostrano forti misure di sicurezza nell’ambiente del browser rispetto ai test API, causando discrepanze nelle loro prestazioni di sicurezza.

Queste limitazioni evidenziano il requisito di misure di sicurezza più uniformi in vari scopi riferimenti. Affrontare queste sfide sarebbe importante per garantire il successo a lungo termine e l’efficacia dell’attrezzatura nel promuovere la sicurezza dell’IA.

AI Promozione della cooperazione in sicurezza

Gli sviluppatori sottolineano l’importanza della cooperazione nel miglioramento della sicurezza dell’IA. Condividendo le loro attrezzature e incoraggiando il contributo alla comunità più ampia, mirano a promuovere uno sforzo collettivo per affrontare le debolezze del sistema AI. Gli esperimenti responsabili sono importanti per comprendere questi punti deboli e sviluppare una difesa efficace.

La tua partecipazione a questo sforzo può svolgere un ruolo importante nel modellare il futuro della sicurezza dell’IA. Partecipando attivamente ai test e al raffinamento, puoi aiutare a garantire che i sistemi AI siano in grado di affrontare le sfide del mondo sicuro, affidabile e rapidamente connesso.

Credito mediatico: Su tutti

Archiviato sotto: AI, notizie migliori

Ultime offerte di gadget geek

Divulgazione: Alcuni dei nostri articoli includono collegamenti associati. Se acquisti qualcosa attraverso uno di questi link, il gadget geek può guadagnare una commissione affiliata. Scopri la nostra politica di divulgazione.