Una tazza di caffè che afferra può renderlo semplice per gli umani, ma copiare la coordinazione spontanea della visione e del tocco nel robot è una sfida per molto tempo. Ora, un team di ricerca internazionale ha svelato un sistema di successo che integra le informazioni visive e touch, consente alle armi robot di adattarsi in modo più naturale

il loro ambiente.

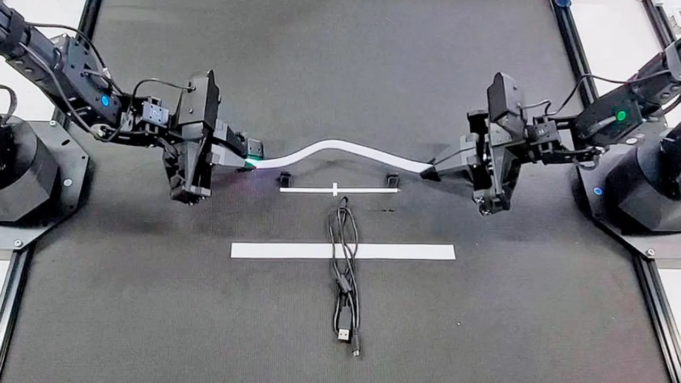

Soprannominato confronto, il metodo basato sulla piattaforma robot a doppio braccio Alooha aperto dell’Università di Stanford, tradizionalmente dipendeva dalla visione. Aggiungendo la sensazione tattile, i ricercatori hanno scoperto che i robot potrebbero separare trame e orientamenti di oggetti migliori, come l’allineamento delle strisce di velcro.

Secondo le conclusioni pubblicate il 2 luglio 2025 nelle lettere di robotica e automazione IEEEE, l’approccio, gestito dalla tecnologia del trasformatore di visione-tecnica, è migliorato in modo significativo rispetto al sistema tradizionale a livello di visione, rispetto al sistema di visione tradizionale.

Link video: https://youtu.be/tounn- ftdo8